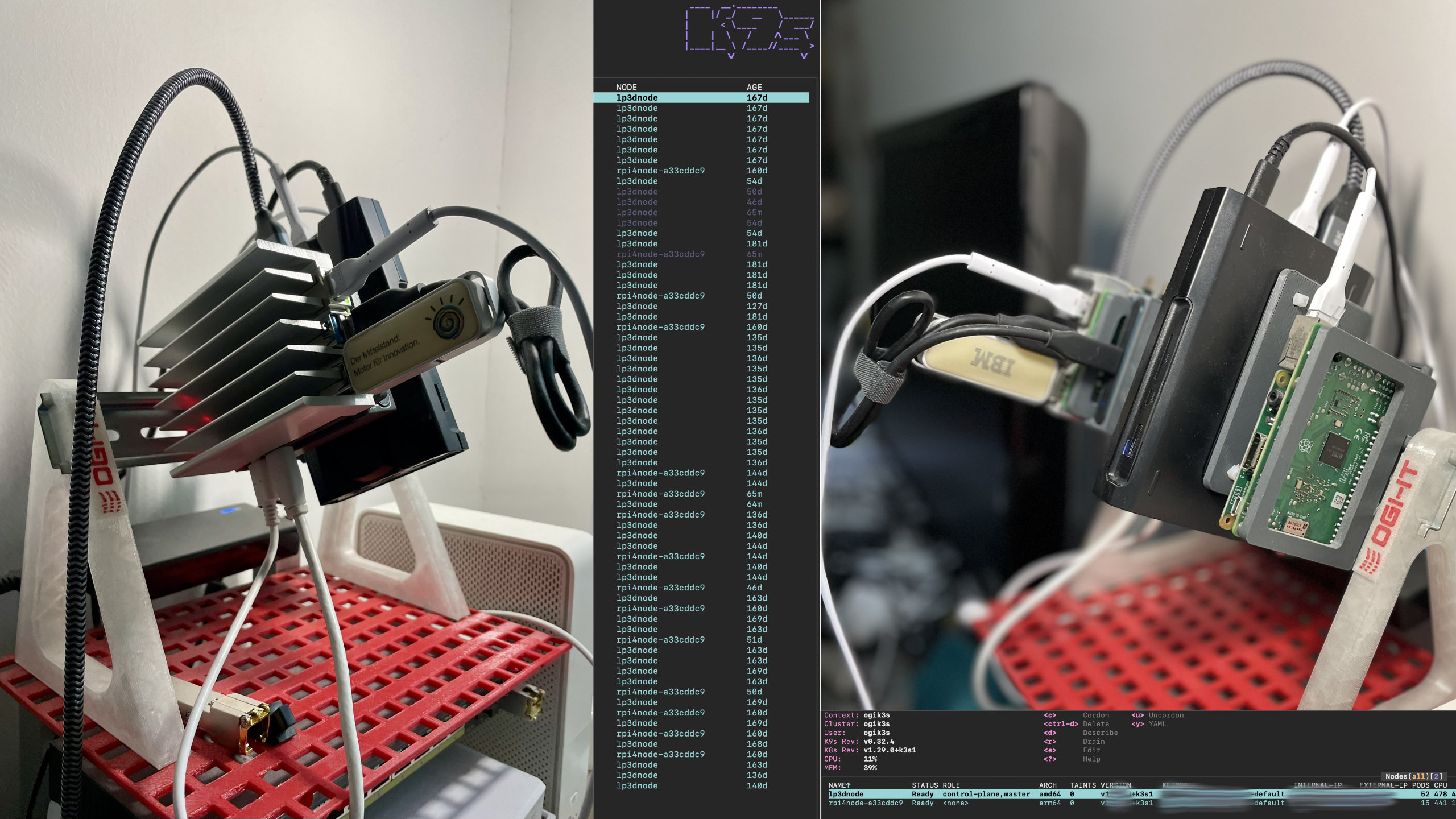

Die Verwendung von Kubernetes in der Cloud ist relativ einfach. Doch wie kann man einen Kunden davon überzeugen, dass sich eine auf Kubernetes basierende Microservices-Architektur auch für Aufgaben eignet die auf einer lokalen Kunden-Hardware laufen? Der Einsatz von Kairos “on the Edge” mit einem Cluster unter Verwendung von ARM- und Intel-Knoten ist ein erster Schritt. Und wenn die Knoten dieses Clusters sodann Low-End-CPUs wie Raspberry Pi 4 und Intel Celeron verwenden und die Kunden-Apps immer noch gut funktionieren, dann könnte das ein sehr gutes Argument sein.

Bei der (Software-)Entwicklung immer auf dem neuesten Stand der Technik zu bleiben ist nicht immer einfach. Das zahlt sich aber langfristig aus. Das Gleiche galt, als wir begannen, Kairos für den internen Entwicklungs- und Demo-Kubernetes-Cluster zu verwenden. Wenn man Tag für Tag mit dieser Technologie arbeitet und Version für Version der Kairos-Software installiert, kann man die Vor- und Nachteile davon erkennen. Dadurch lernt man auch wie man das gesamte System so gestaltet, dass Fallstricke vermieden werden. Mittlerweile hat sich Kairos so weit entwickelt, dass es Produktiv eingesetzt werden kann, und wir nutzen es gerne.